Top 5 Casos de uso de scraping de web para automatización, aprendizaje automático e insights empresariales

Adélia Cruz

Neural Network Developer

17-Oct-2025

En el contexto de la revolución digital, los datos se han convertido en el activo más valioso para una empresa. Web Scraping, la tecnología clave para adquirir de manera eficiente grandes cantidades de información pública en línea, está cada vez más convirtiéndose en la base para impulsar la automatización empresarial, potenciar modelos de aprendizaje automático y profundizar en las perspectivas comerciales. Ya no es solo una herramienta técnica, sino una capacidad estratégica crítica para que las empresas obtengan una ventaja competitiva y permitan la toma de decisiones en tiempo real.

Este artículo explorará las cinco aplicaciones principales del web scraping en los tres dominios estratégicos de "Automatización", "Aprendizaje Automático" y "Perspectivas Empresariales". Ofreceremos perspectivas únicas y consejos prácticos para ayudar a las empresas a superar a sus competidores y construir un negocio de alto valor basado en datos.

I. Web Scraping: Un salto de la tecnología a la estrategia

Los métodos tradicionales de investigación de mercado y recolección de datos suelen ser laboriosos, costosos y carecer de capacidades en tiempo real. El web scraping, al utilizar programas automatizados (crawlers) para simular el comportamiento de navegación humano y extraer datos estructurados de páginas web, mejora significativamente la eficiencia y el alcance de la adquisición de datos.

Tres valores estratégicos del web scraping:

- Automatización: Delegar tareas repetitivas y laboriosas de recolección de datos a las máquinas, liberando recursos humanos para enfocarse en el análisis y la toma de decisiones.

- Aprendizaje Automático: Proporcionar conjuntos de datos de entrenamiento a gran escala, de alta calidad y personalizados para modelos de IA complejos, el "sangre de los modelos".

- Perspectivas Empresariales: Ofrecer una panorámica en tiempo real y completa del mercado, apoyando la fijación dinámica de precios, el análisis de la competencia y la predicción de tendencias.

II. Análisis detallado de cinco escenarios de aplicación principales

Analizaremos los cinco escenarios de aplicación más impactantes, que no solo son prácticas comunes en la industria, sino también clave para lograr una competencia diferenciada.

1. Potenciando modelos de aprendizaje automático: La "tubería de datos" para datos de entrenamiento de alta calidad

En la era de la Inteligencia Artificial, la verdad de que "los datos determinan el límite superior de un modelo" es ampliamente aceptada. El web scraping es el método más efectivo para construir conjuntos de datos de entrenamiento de alta calidad y personalizados.

| Desafío | Solución de web scraping | Valor único e insight |

|---|---|---|

| Los conjuntos de datos públicos están obsoletos o son irrelevantes | Escaneo en tiempo real de datos específicos del dominio para garantizar la frescura y relevancia de los datos. | Generación de etiquetas personalizadas: Al escanear reseñas, etiquetas o información de clasificación de sitios web específicos, se pueden generar etiquetas más granulares de forma automática para los datos, superando significativamente la granularidad de los conjuntos de datos generales. |

| Volumen insuficiente de datos | Escaneo escalable de texto, imágenes, metadatos de video, etc., para construir rápidamente conjuntos de datos de millones de elementos. | Fusión de datos multimodales: Escanear no solo texto, sino también descripciones de imágenes asociadas y datos de interacción del usuario, para entrenar modelos de IA más complejos de múltiples modos. |

| Sesgo en los datos | Escaneo de datos desde múltiples fuentes diferentes para validación cruzada y equilibrio, reduciendo el sesgo de datos provenientes de una sola fuente. | Monitoreo de desviación de datos: Escanear datos de forma continua y compararlos con los datos de entrenamiento del modelo para detectar de manera oportuna cambios en la distribución de datos (desviación de datos), guiando el reentrenamiento del modelo. |

【Consejo práctico】: Al escanear datos para modelos de ML, el proceso de limpieza y estructuración de los datos debe considerarse un componente principal del flujo de escaneo, asegurando la uniformidad del formato de los datos y la precisión de las etiquetas.

2. Monitoreo en tiempo real de precios competitivos y estrategia de precios dinámicos

En los sectores de comercio electrónico y retail, el precio es el factor más directo que influye en las decisiones de compra de los consumidores. El web scraping permite el monitoreo a nivel de milisegundos de los precios, inventario y actividades promocionales de los competidores, apoyando así estrategias de precios dinámicos.

Al escanear continuamente los precios de los SKU (Unidades de Control de Inventario), información de descuentos y estado de inventario de los principales competidores, las empresas pueden alimentar estos datos en sus algoritmos de precios. Los modelos de aprendizaje automático pueden ajustar los precios de los productos en tiempo real en función de la elasticidad de la demanda, los movimientos de los competidores y los datos históricos de ventas para maximizar las ganancias o la cuota de mercado.

【Valor diferenciado】: Más allá de los precios, escanear "historial de cambios de precios" y "estrategias de ventas por paquetes" proporciona una comprensión más profunda. Por ejemplo, analizar la magnitud de los ajustes de precios de un competidor durante festividades específicas puede predecir su comportamiento de marketing futuro.

3. Análisis de sentimiento del mercado y gestión de la reputación de la marca

Las redes sociales, foros, sitios de noticias y secciones de reseñas en comercio electrónico contienen una gran cantidad de datos de sentimiento de los consumidores. Al escanear estos datos de texto no estructurados y combinarlos con la tecnología de Procesamiento de Lenguaje Natural (NLP), las empresas pueden realizar un gran análisis de sentimiento.

- Perspectivas empresariales: Comprender instantáneamente la retroalimentación del mercado después del lanzamiento de un nuevo producto, identificando rápidamente defectos del producto o puntos de dolor en el servicio.

- Automatización: Identificar automáticamente comentarios negativos y señales de crisis, activando un sistema de alerta temprana para la gestión automatizada de la reputación de la marca.

【Insight único】: La granularidad del análisis de sentimiento debe refinarse desde el nivel de "producto" al nivel de "característica del producto". Por ejemplo, al escanear reseñas de un teléfono móvil, analizar el sentimiento no solo del producto en su totalidad, sino también de palabras clave específicas como "vida de la batería" y "rendimiento de la cámara" para guiar la mejora del producto.

4. Generación automatizada de clientes potenciales y expansión del mercado

Para empresas B2B, encontrar clientes potenciales y socios de mercado es clave para el crecimiento sostenible. El web scraping puede automatizar este proceso tedioso.

Al escanear datos de directorios industriales, listas de empresas, tableros de empleo y plataformas sociales profesionales , se puede construir una base de datos de clientes objetivo, incluyendo nombres de empresas, contactos, títulos de empleo, tecnologías utilizadas y tamaño de la empresa.

【Consejo práctico】: Combinar esto con las soluciones de CAPTCHA mencionadas en los hipervínculos internos puede contrarrestar de manera más efectiva las mecanismos anti-scraping de los sitios web objetivo, asegurando la continuidad y precisión de los datos de clientes potenciales. Por ejemplo, usar una herramienta como CapSolver para resolver desafíos complejos de AWS WAF o reCAPTCHA asegura que el proceso de escaneo automatizado no se interrumpa.

Lectura adicional: Resolver desafíos complejos de CAPTCHA es un paso crítico en la adquisición de clientes potenciales de alta calidad. Aprende más sobre la información de resolver AWS WAF CAPTCHA y reCAPTCHA v2/v3.

5. Inteligencia del mercado financiero y predicción de riesgos

La industria financiera exige estándares extremadamente altos en cuanto a capacidad de datos en tiempo real y precisión. El web scraping desempeña un papel irremplazable en inteligencia financiera, trading algorítmico y gestión de riesgos.

- Perspectivas empresariales: Escanear informes en tiempo real de agencias de noticias, anuncios regulatorios (como documentos de la SEC) y discusiones financieras en redes sociales para construir estrategias de trading basadas en eventos.

- Aprendizaje Automático: Entrenar modelos para identificar indicadores de sentimiento y índices de incertidumbre dentro de los textos de noticias para predecir fluctuaciones a corto plazo en los precios de las acciones.

【Valor diferenciado】: Más allá del escaneo de datos financieros tradicionales, escanear datos de la cadena de suministro (como información pública sobre seguimiento de envíos y estado de producción en fábricas) puede proporcionar señales tempranas de macroeconomía para decisiones de inversión, una ventaja única que a menudo carecen las fuentes tradicionales de datos financieros.

III. Comparación de selección de tecnología de web scraping: eficiencia frente a medidas anti-bot

Elegir la pila de tecnología adecuada es crucial al implementar un proyecto de web scraping. A continuación se presenta una comparación de varios métodos de scraping principales en términos de eficiencia, capacidad anti-bot y costo:

| Característica | Crawler construido por sí mismo (por ejemplo, Python/Scrapy) | Servicio comercial de scraping (por ejemplo, Scraping API) | Navegador headless (por ejemplo, Puppeteer/Playwright) |

|---|---|---|---|

| Costo de desarrollo | Alto (Requiere manejar todos los detalles) | Bajo (Llamada a API, integración rápida) | Medio (Requiere manejar el entorno del navegador y el consumo de recursos) |

| Eficiencia de scraping | Extremadamente alta (Optimizada para objetivos específicos) | Alta (El proveedor maneja el mantenimiento) | Más baja (Alto consumo de recursos, menor velocidad) |

| Capacidad anti-bot | Alta (Estrategias anti-bot personalizables) | Extremadamente alta (Un equipo profesional maneja el proxy y el fingerprinting) | Media (Simula el comportamiento de un navegador real) |

| Dificultad de mantenimiento | Extremadamente alta (Se necesitan actualizaciones frecuentes para cambios en la estructura del sitio web) | Baja (El proveedor maneja el mantenimiento) | Media (Actualizaciones del navegador y configuración del entorno) |

| Mejor caso de uso | Proyectos a largo plazo, a gran escala y altamente personalizados | Necesidades comerciales rápidas, estables y de alta concurrencia | Escenarios que requieren ejecución compleja de JavaScript o inicio de sesión |

【Insight único】: Para aplicaciones comerciales que exigen alta eficiencia y fuertes capacidades anti-bot, un servicio comercial de scraping suele ser la opción más rentable, ya que subcontrata el trabajo complejo de gestión de proxies y mantenimiento anti-bot a un equipo especializado.

IV. Desafíos y contramedidas en la implementación de web scraping

Aunque el web scraping tiene un gran potencial, su operación práctica aún enfrenta numerosos desafíos, especialmente en escenarios que involucran recolección a gran escala y alta frecuencia.

Desafío 1: Aumento de mecanismos anti-bot

Los mecanismos anti-bot de los sitios web se están volviendo cada vez más sofisticados, desde bloques de IP simples hasta análisis de comportamiento complejo, fingerprinting de TLS y desafíos de CAPTCHA.

Contramedidas:

- Usar servicios de proxies de alta calidad: Combinar proxies residenciales o de centros de datos para rotar IPs y evitar ser bloqueado.

- Simular el comportamiento de un usuario real: Usar navegadores headless para simular movimientos del mouse, desplazamiento y clics, y modificar parámetros como User-Agent y Headers para imitar un usuario regular.

- Integrar soluciones de CAPTCHA: Para desafíos como reCAPTCHA, clouflare o CAPTCHA de AWS WAF, integrar servicios profesionales de resolución de CAPTCHA (como CapSolver) para lograr un bypass automatizado.

Desafío 2: Límites legales y éticos

El escaneo de datos debe cumplir con leyes, regulaciones y los Términos de Servicio del sitio web.

Contramedidas:

- Escaneo solo de datos públicos: Evitar estrictamente escanear datos personales privados o datos que requieran acceso de inicio de sesión.

- Cumplir con el protocolo robots.txt: Verificar el archivo

robots.txtdel sitio web objetivo antes de escanear y respetar las restricciones de escaneo del propietario. - Controlar la frecuencia de escaneo: Establecer intervalos de solicitud razonables para evitar sobrecargar los servidores del sitio web objetivo.

V. Conclusión y perspectiva

El web scraping es una parte indispensable de la estrategia basada en datos de una empresa moderna. Al aplicarlo a áreas clave como la generación de datos de entrenamiento para IA, precios dinámicos, análisis de sentimiento del mercado, generación automatizada de clientes potenciales y inteligencia financiera, las empresas pueden obtener perspectivas comerciales precisas y en tiempo real y mantener una ventaja competitiva.

Una estrategia exitosa de web scraping no solo radica en el avance tecnológico, sino también en el cumplimiento de regulaciones legales, el respeto a la ética de los datos y la adaptación continua a los desafíos anti-bot. Con el desarrollo continuo de la tecnología de IA, el futuro del web scraping será más inteligente y adaptable, brindando una profundidad y amplitud sin precedentes en la toma de decisiones empresariales.

Apéndice: Preguntas frecuentes (FAQ)

P1: ¿Es legal el web scraping?

R1: La legalidad del web scraping depende del contenido específico y del método de scraping. Generalmente, el scraping de datos accesibles públicamente (sin inicio de sesión, sin información privada) es legal. Sin embargo, debe cumplir estrictamente con el protocolo robots.txt del sitio web objetivo y sus Términos de Servicio. El scraping de contenido con derechos de autor o datos personales privados es ilegal. Es recomendable consultar a profesionales legales y siempre realizar la recolección de datos de manera responsable y ética.

P2: ¿Se puede usar directamente los datos escaneados para modelos de aprendizaje automático?

R2: Generalmente no. Los datos crudos escaneados a menudo contienen ruido significativo, valores faltantes, formatos inconsistentes y otros problemas. Antes de ser utilizados para modelos de aprendizaje automático, deben pasar por pasos rigurosos de preprocesamiento como Limpieza de datos, Transformación de datos y Ingeniería de características para garantizar la calidad de los datos y la precisión del modelo.

P3: ¿Cuál es la diferencia entre web scraping y llamadas a API?

R3: Un API (Interfaz de Programación de Aplicaciones) es una interfaz oficial proporcionada proactivamente por un sitio web o servicio para obtener datos estructurados; es estable, eficiente y legal. El web scraping extrae datos del contenido HTML de un sitio web y se usa cuando no hay API o cuando su funcionalidad es limitada. Siempre que sea posible, priorizar el uso de la API; considerar el web scraping solo cuando la API no esté disponible o no sea suficiente para sus necesidades.

P4: ¿Cómo ayuda CapSolver con los problemas de CAPTCHA en el web scraping?

R4: CapSolver es un servicio profesional de resolución automatizada de CAPTCHA. Utiliza tecnología avanzada de IA y aprendizaje automático para reconocer y resolver automáticamente diversos tipos complejos de CAPTCHA, como reCAPTCHA v2/v3, Cloudflare y CAPTCHA de AWS WAF, entre otros. Al integrar la API de CapSolver en su flujo de trabajo de scraping, puede lograr una recolección automatizada de datos sin interrupciones, resolviendo eficazmente los obstáculos de CAPTCHA en los mecanismos anti-bot.

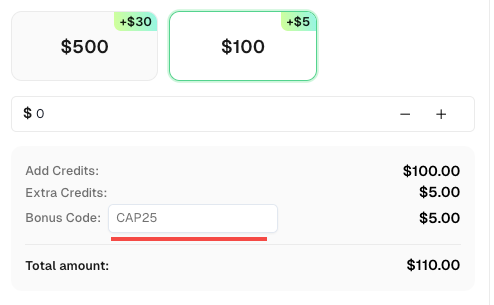

Redime tu código de bono de CapSolver

¡No pierdas la oportunidad de optimizar aún más tus operaciones! Usa el código de bono CAP25 al recargar tu cuenta de CapSolver y recibe un bono adicional del 5% en cada recarga, sin límites. Visita el Panel de CapSolver para redimir tu bono ahora!

P6: ¿Cómo puedo asegurar que mi web scraping sea sostenible (es decir, no se rompa debido a cambios en la estructura del sitio web)?

R6: Los cambios en la estructura del sitio web son uno de los mayores desafíos para el scraping. Las contramedidas incluyen:

- Usar una combinación de selectores CSS o XPath: No dependa de un solo selector muy específico.

- Establecer un sistema de monitoreo y alertas: Verifique periódicamente el estado de la extracción de los puntos de datos clave y active inmediatamente una alerta si la extracción falla.

- Usar herramientas de extracción impulsadas por IA: Algunas herramientas avanzadas (como los extrayentes basados en prompts mencionados en el enlace interno) pueden usar IA para adaptarse a pequeños cambios en la estructura del sitio web, reduciendo los costos de mantenimiento.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

Cómo resolver reCAPTCHA al realizar el raspado de resultados de búsqueda con Puppeteer

Dominar el arte de la extracción de datos con Puppeteer al aprender a resolver de manera confiable reCAPTCHA v2 y v3. Descubra las mejores técnicas para resolver reCAPTCHA con Puppeteer para la extracción a gran escala de datos y la automatización de SEO.

Adélia Cruz

06-Nov-2025

¿Qué es la recopilación de datos: últimas noticias sobre scraping web en 2024?

Aprende todo sobre la recolección de datos — desde los métodos de scraping web y aplicaciones del mundo real hasta superar barreras CAPTCHA usando CapSolver. Descubre cómo recopilar, limpiar y analizar datos valiosos de sitios web, documentos y conjuntos de datos de manera eficiente.

Adélia Cruz

04-Nov-2025

Mejor Servicio de Resolución de CAPTCHA 2026, ¿Cuál es el mejor servicio de CAPTCHA?

Compara los mejores servicios de resolución de CAPTCHA para 2026. Descubre la ventaja de inteligencia artificial de vanguardia de CapSolver en velocidad, precisión del 99%+ y compatibilidad con Captcha Challenge.

Adélia Cruz

30-Oct-2025

Mejor solución para resolver Captcha al raspar, ¿Qué es el raspado de web?

Descubre la mejor solución para resolver CAPTCHAs mientras realizas scraping y aprende qué es el scraping web y cómo ayuda a automatizar la recopilación de datos.

Adélia Cruz

30-Oct-2025

Web Scraping vs API: Recopilar datos con web scraping y API

Aprende las diferencias entre el raspado de web y las APIs, sus ventajas y desventajas, y qué método es el mejor para recopilar datos web estructurados o no estructurados de manera eficiente.

Adélia Cruz

29-Oct-2025

Solucionador de CAPTCHA de AWS WAF: Solución de Token e Imagen para Scrapers

Aprende a resolver desafíos de CAPTCHA de AWS WAF para el raspado web y la automatización. Guía práctica sobre soluciones basadas en tokens y en imágenes, integración de API frente al navegador y mejores prácticas.

Adélia Cruz

28-Oct-2025