Desafíos de Web Scraping y cómo resolverlos

Aloísio Vítor

Image Processing Expert

28-Oct-2025

Internet es un vasto repositorio de datos, pero aprovechar su verdadero potencial puede ser un desafío. Ya sea que se trate de manejar datos en un formato no estructurado, navegar por limitaciones impuestas por los sitios web, o enfrentar diversos obstáculos, acceder y utilizar datos web de manera efectiva requiere superar grandes barreras. Es aquí donde el web search se vuelve invaluable. Al automatizar la extracción y procesamiento de contenido web no estructurado, se puede compilar conjuntos de datos extensos que proporcionen información valiosa y una ventaja competitiva.

Sin embargo, los entusiastas y profesionales del web data enfrentan numerosos desafíos en este dinámico entorno en línea. En este artículo, exploraremos los 5 principales desafíos de web search que tanto principiantes como expertos deben conocer. Además, profundizaremos en las soluciones más efectivas para superar estas dificultades.

Sumérjase más profundamente en el mundo del web search y descubra cómo superar estos desafíos.

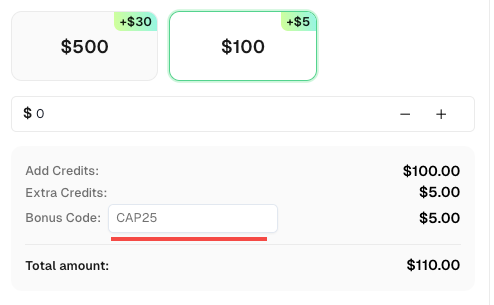

Código de regalo

¡No te pierdas la oportunidad de optimizar aún más tus operaciones! Usa el código de regalo CAP25 al recargar tu cuenta de CapSolver y recibe un 5% adicional en cada recarga, sin límites. Visita el Panel de control de CapSolver para reclamar tu regalo ahora!

Bloqueo de IP

Para prevenir el abuso y el scraping no autorizado, los sitios web a menudo emplean medidas de bloqueo que dependen de identificadores únicos como las direcciones IP. Cuando ciertos límites son excedidos o se detectan actividades sospechosas, el sitio web puede prohibir la dirección IP asociada, impidiendo efectivamente el scraping automatizado.

Los sitios web también pueden implementar geo-bloqueo, que prohíbe IPs según su ubicación geográfica, así como otras medidas anti-robots que analizan el origen de la IP y patrones de uso inusuales para identificar y bloquear IPs.

Solución

Afortunadamente, existen varias soluciones para superar el bloqueo de IP. El enfoque más sencillo implica ajustar tus solicitudes para cumplir con los límites del sitio web, controlar la frecuencia de las solicitudes y mantener un patrón de uso natural. Sin embargo, este enfoque restringe significativamente la cantidad de datos que se pueden extraer en un período determinado.

Una solución más escalable es utilizar un servicio de proxy que incluya rotación de IPs y mecanismos de reintentos para evadir el bloqueo de IP. Es importante tener en cuenta que el scraping web usando proxies y otros métodos de evasión puede generar preocupaciones éticas. Siempre asegúrate de cumplir con las regulaciones locales e internacionales sobre datos y revisa cuidadosamente los Términos de Servicio (TOS) y políticas del sitio web antes de proceder.

CAPTCHAs

CAPTCHAs, que significa "Pruebas de Turing Públicas Automatizadas para Distinguir entre Computadoras y Humanos", son una medida de seguridad ampliamente utilizada para impedir que los scrapers web accedan y extraigan datos de los sitios web.

Este sistema presenta desafíos que requieren interacción manual para probar la autenticidad del usuario antes de otorgar acceso al contenido deseado. Estos desafíos pueden tomar diversas formas, incluyendo reconocimiento de imágenes, acertijos textuales, acertijos auditivos o incluso análisis del comportamiento del usuario.

Solución

Para superar los CAPTCHAs, uno puede resolverlos o tomar medidas para evitar activarlos. Generalmente se recomienda optar por la primera opción, ya que garantiza la integridad de los datos, aumenta la eficiencia de la automatización, proporciona confiabilidad y estabilidad, y cumple con los lineamientos legales y éticos. Evitar activar CAPTCHA puede resultar en datos incompletos, operaciones manuales aumentadas, uso de métodos no compatibles y exposición a riesgos legales y éticos. Por lo tanto, abordar el CAPTCHA es una forma más confiable y sostenible.

CapSolver, por ejemplo, es un servicio de terceros dedicado a resolver Captchas. Ofrece una API que se puede integrar directamente en scripts de scraping o aplicaciones.

Al externalizar la resolución de CAPTCHA a servicios como Capsolver, puedes agilizar el proceso de scraping y reducir la intervención manual.

Límites de velocidad

El límite de velocidad es un método utilizado por los sitios web para protegerse contra abusos y diferentes tipos de ataques. Establece límites en el número de solicitudes que un cliente puede realizar en un período determinado. Si se excede el límite, el sitio web puede limitar o bloquear las solicitudes utilizando técnicas como el bloqueo de IP o CAPTCHA.

El límite de velocidad se centra principalmente en identificar clientes individuales y monitorear su uso para garantizar que se mantengan dentro de los límites establecidos. La identificación puede basarse en la dirección IP del cliente o utilizar técnicas como la huella digital del navegador, que consiste en detectar características únicas del cliente. También pueden examinarse las cadenas de agente de usuario y cookies como parte del proceso de identificación.

Solución

Hay varias formas de superar los límites de velocidad. Un enfoque sencillo es controlar la frecuencia y el momento de tus solicitudes para imitar un comportamiento más humano. Esto puede incluir introducir retrasos aleatorios o reintentos entre solicitudes. Otras soluciones implican rotar tu dirección IP y personalizar diversas propiedades, como la cadena de agente de usuario y la huella digital del navegador.

Trampas de miel

Las trampas de miel representan un desafío significativo para los bots de scraping web, ya que están diseñadas específicamente para engañar a los scripts automatizados. Estas trampas implican la inclusión de elementos o enlaces ocultos que están destinados a ser accedidos solo por bots.

El propósito de las trampas de miel es identificar y bloquear actividades de scraping, ya que los usuarios reales no interactuarían con estos elementos ocultos. Cuando un scraper encuentra y interactúa con estas trampas, se activa una alerta, lo que podría llevar a que el scraper sea prohibido del sitio web.

Solución

Para superar este desafío, es crucial estar alerta y evitar caer en trampas de miel. Una estrategia efectiva es identificar y evitar enlaces ocultos. Estos enlaces suelen estar configurados con propiedades CSS como display: none o visibility: hidden, lo que los hace invisibles para los usuarios humanos pero detectables por los bots de scraping.

Al analizar cuidadosamente la estructura HTML y las propiedades CSS de las páginas web que estás raspando, puedes excluir o evitar estos enlaces ocultos. De esta manera, minimizas el riesgo de activar trampas de miel y mantienes la integridad y estabilidad de tu proceso de scraping.

Es importante tener en cuenta que respetar las políticas y Términos de Servicio del sitio web es esencial al realizar actividades de scraping. Siempre asegúrate de que tus actividades de scraping se alineen con las directrices éticas y legales establecidas por los propietarios del sitio web.

Contenido dinámico

Además de los límites de velocidad y el bloqueo, el scraping web presenta desafíos relacionados con la detección y manejo de contenido dinámico.

Los sitios web modernos a menudo incorporan una gran cantidad de JavaScript para mejorar la interactividad y renderizar dinámicamente varias partes de la interfaz de usuario, contenido adicional o incluso páginas completas.

Con la prevalencia de aplicaciones de página única (SPAs), el JavaScript desempeña un papel crucial en el renderizado de casi todos los aspectos del sitio web. Además, otros tipos de aplicaciones web utilizan JavaScript para cargar contenido de manera asincrónica, permitiendo funciones como el scroll infinito sin necesidad de recargar la página. En tales casos, analizar solo el HTML no es suficiente.

Para raspar contenido dinámico con éxito, es necesario cargar y procesar el código JavaScript subyacente. Sin embargo, implementar esto correctamente en un script personalizado puede ser desafiante. Por eso, muchos desarrolladores prefieren utilizar navegadores headless y herramientas de automatización web como Playwright, Puppeteer y Selenium.

Al aprovechar estas herramientas, puedes emular un entorno de navegador, ejecutar JavaScript y obtener el HTML completamente renderizado, incluido cualquier contenido cargado dinámicamente. Este enfoque asegura que captures toda la información deseada, incluso en sitios web que dependen en gran medida de JavaScript para la generación de contenido.

Carga lenta de páginas

Cuando un sitio web experimenta un alto volumen de solicitudes concurrentes, su velocidad de carga puede verse significativamente afectada. Factores como el tamaño de la página, la latencia de la red, el rendimiento del servidor y la cantidad de JavaScript y otros recursos a cargar contribuyen a este problema.

La carga lenta de páginas puede causar retrasos en la recuperación de datos durante el scraping. Esto puede ralentizar todo el proyecto de scraping, especialmente cuando se trata de múltiples páginas. También puede provocar tiempos de espera, tiempos de scraping impredecibles, extracción de datos incompleta o datos incorrectos si ciertos elementos de la página no se cargan correctamente.

Solución

Para abordar este desafío, se recomienda usar navegadores headless como Selenium o Puppeteer. Estas herramientas te permiten asegurarte de que una página esté completamente cargada antes de extraer datos, evitando información incompleta o incorrecta. Configurar tiempos de espera, reintents o refrescos, y optimizar tu código también puede ayudar a mitigar el impacto de la carga lenta de páginas.

Conclusión

Enfrentamos varios desafíos al realizar web scraping. Estos desafíos incluyen el bloqueo de IP, verificación de CAPTCHA, límites de velocidad, trampas de miel, contenido dinámico y carga lenta de páginas. Sin embargo, podemos superar estos desafíos usando proxies, resolviendo CAPTCHAs, controlando la frecuencia de las solicitudes, evitando trampas, utilizando navegadores headless y optimizando nuestro código. Al abordar estos obstáculos, podemos mejorar nuestros esfuerzos de web scraping, recopilar información valiosa y garantizar el cumplimiento.

Preguntas frecuentes: Preguntas comunes sobre los desafíos del web scraping

1. ¿Qué es el web scraping y por qué es importante?

El web scraping es el proceso automatizado de recopilar y extraer datos de sitios web. Se utiliza ampliamente para investigación de mercado, seguimiento de SEO, análisis de datos y aprendizaje automático. El scraping eficiente ayuda a las empresas a obtener insights y mantener una ventaja competitiva.

2. ¿Por qué los sitios web bloquean a los scrapers?

Los sitios web bloquean a los scrapers para prevenir el uso indebido, proteger el rendimiento del servidor y garantizar la seguridad de los datos privados. Los métodos comunes anti-robots incluyen el bloqueo de IP, la verificación de CAPTCHA y la identificación mediante huella digital del navegador.

3. ¿Cómo puedo resolver el CAPTCHA durante el web scraping?

Puedes usar servicios de resolución de CAPTCHA de terceros como CapSolver. Ofrece APIs para resolver automáticamente reCAPTCHA, hCaptcha y otros tipos de CAPTCHA, asegurando una recopilación ininterrumpida de datos.

4. ¿Cuál es la mejor manera de evitar el bloqueo de IP al raspar sitios web?

Usa proxies rotatorios y controla la frecuencia de tus solicitudes. Enviar demasiadas solicitudes en un corto período de tiempo puede activar límites de velocidad o prohibiciones. Se recomienda fuertemente usar proxies residenciales y prácticas éticas de scraping.

5. ¿Cómo manejo contenido dinámico o con mucho JavaScript?

Los sitios web modernos a menudo usan frameworks de JavaScript como React o Vue, que cargan contenido dinámicamente. Herramientas como Puppeteer, Playwright o Selenium simulan un entorno de navegador para renderizar y raspar datos de página completa de manera efectiva.

6. ¿Hay preocupaciones legales o éticas con el web scraping?

Sí. Siempre debes cumplir con los Términos de Servicio (TOS) del sitio web y leyes de privacidad de datos (como GDPR o CCPA). Enfócate en datos disponibles públicamente y evita raspar información sensible o restringida.

7. ¿Cómo puedo acelerar proyectos de web scraping lentos?

Optimiza tus scripts estableciendo tiempos de espera adecuados, almacenando en caché los resultados y usando solicitudes asincrónicas. Además, resolver CAPTCHAs eficientemente con CapSolver y usar proxies rápidos puede reducir retrasos y mejorar la estabilidad.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

Cómo resolver reCAPTCHA al realizar el raspado de resultados de búsqueda con Puppeteer

Dominar el arte de la extracción de datos con Puppeteer al aprender a resolver de manera confiable reCAPTCHA v2 y v3. Descubra las mejores técnicas para resolver reCAPTCHA con Puppeteer para la extracción a gran escala de datos y la automatización de SEO.

Adélia Cruz

06-Nov-2025

¿Qué es la recopilación de datos: últimas noticias sobre scraping web en 2024?

Aprende todo sobre la recolección de datos — desde los métodos de scraping web y aplicaciones del mundo real hasta superar barreras CAPTCHA usando CapSolver. Descubre cómo recopilar, limpiar y analizar datos valiosos de sitios web, documentos y conjuntos de datos de manera eficiente.

Adélia Cruz

04-Nov-2025

Mejor Servicio de Resolución de CAPTCHA 2026, ¿Cuál es el mejor servicio de CAPTCHA?

Compara los mejores servicios de resolución de CAPTCHA para 2026. Descubre la ventaja de inteligencia artificial de vanguardia de CapSolver en velocidad, precisión del 99%+ y compatibilidad con Captcha Challenge.

Adélia Cruz

30-Oct-2025

Mejor solución para resolver Captcha al raspar, ¿Qué es el raspado de web?

Descubre la mejor solución para resolver CAPTCHAs mientras realizas scraping y aprende qué es el scraping web y cómo ayuda a automatizar la recopilación de datos.

Adélia Cruz

30-Oct-2025

Web Scraping vs API: Recopilar datos con web scraping y API

Aprende las diferencias entre el raspado de web y las APIs, sus ventajas y desventajas, y qué método es el mejor para recopilar datos web estructurados o no estructurados de manera eficiente.

Adélia Cruz

29-Oct-2025

Solucionador de CAPTCHA de AWS WAF: Solución de Token e Imagen para Scrapers

Aprende a resolver desafíos de CAPTCHA de AWS WAF para el raspado web y la automatización. Guía práctica sobre soluciones basadas en tokens y en imágenes, integración de API frente al navegador y mejores prácticas.

Adélia Cruz

28-Oct-2025