Tantangan Pengambilan Data Web dan Cara Mengatasinya

Ethan Collins

Pattern Recognition Specialist

28-Oct-2025

Internet adalah gudang data yang luas, tetapi memanfaatkan potensinya secara penuh bisa menjadi tantangan. Baik itu menghadapi data dalam format yang tidak terstruktur, mengatasi batasan yang diberlakukan oleh situs web, atau menghadapi berbagai hambatan, mengakses dan memanfaatkan data web secara efektif memerlukan pengatasan hambatan yang signifikan. Inilah saatnya web search menjadi sangat berharga. Dengan mengotomasi ekstraksi dan pemrosesan konten web yang tidak terstruktur, seseorang dapat mengumpulkan dataset yang luas yang memberikan wawasan berharga dan keunggulan kompetitif.

Namun, penggemar dan profesional pengambilan data web sering menghadapi berbagai tantangan dalam lingkungan online yang dinamis. Dalam artikel ini, kita akan menjelajahi 5 tantangan utama dalam pencarian web yang harus diketahui oleh pemula maupun ahli. Selain itu, kita juga akan membahas solusi terbaik untuk mengatasi kesulitan ini.

Mari kita masuk lebih dalam ke dunia pencarian web dan temukan cara mengatasi tantangan ini!

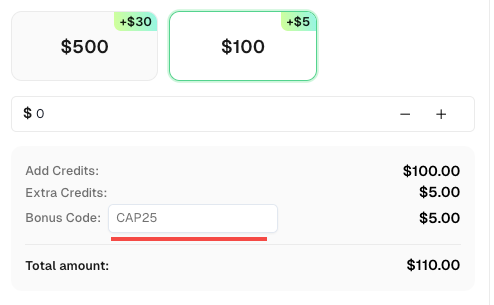

Kode Bonus

Jangan lewatkan kesempatan untuk memperbaiki operasional Anda! Gunakan kode bonus CAP25 saat mengisi ulang akun CapSolver Anda dan dapatkan bonus tambahan 5% untuk setiap pengisian ulang, tanpa batas. Kunjungi Dashboard CapSolver untuk mengklaim bonus Anda sekarang!

Blokir IP

Untuk mencegah penyalahgunaan dan pengambilan data web yang tidak sah, situs web sering menggunakan langkah-langkah pemblokiran yang bergantung pada identifikasi unik seperti alamat IP. Ketika batas tertentu terlebihi atau aktivitas mencurigakan terdeteksi, situs web dapat memblokir alamat IP yang terkait, secara efektif mencegah pengambilan data otomatis.

Situs web juga dapat menerapkan blokir geografis, yang memblokir IP berdasarkan lokasi geografisnya, serta langkah-langkah anti-bot lainnya yang menganalisis asal IP dan pola penggunaan yang tidak biasa untuk mengidentifikasi dan memblokir IP.

Solusi

Untungnya, ada beberapa solusi untuk mengatasi pemblokiran IP. Pendekatan paling sederhana melibatkan penyesuaian permintaan Anda agar sesuai dengan batasan situs web, mengontrol kecepatan permintaan dan menjaga pola penggunaan yang alami. Namun, pendekatan ini secara signifikan membatasi jumlah data yang dapat diambil dalam jangka waktu tertentu.

Solusi yang lebih skalabel adalah menggunakan layanan proxy yang mencakup rotasi IP dan mekanisme retry untuk menghindari pemblokiran IP. Penting untuk dicatat bahwa pengambilan data web menggunakan proxy dan metode lainnya mungkin menimbulkan masalah etis. Selalu pastikan kepatuhan terhadap regulasi data lokal dan internasional serta periksa dengan cermat ketentuan layanan (TOS) dan kebijakan situs web sebelum melanjutkan.

CAPTCHA

CAPTCHA, singkatan dari Completely Automated Public Turing Tests to Tell Computers and Humans Apart, berfungsi sebagai langkah keamanan yang umum digunakan untuk menghambat pengambilan data web oleh web scraper.

Sistem ini memberikan tantangan yang memerlukan interaksi manual untuk membuktikan keaslian pengguna sebelum memberikan akses ke konten yang diinginkan. Tantangan ini dapat berbentuk berbagai jenis, termasuk pengenalan gambar, teka-teki teks, teka-teki audio, atau bahkan analisis perilaku pengguna.

Solusi

Untuk mengatasi CAPTCHA, seseorang dapat menyelesaikannya atau mengambil langkah-langkah untuk menghindari pemicu CAPTCHA. Secara umum, disarankan untuk memilih pendekatan pertama, karena menjamin integritas data, meningkatkan efisiensi otomatisasi, memberikan keandalan dan stabilitas, serta mematuhi panduan hukum dan etis. Menghindari pemicu CAPTCHA dapat mengakibatkan data yang tidak lengkap, peningkatan operasi manual, penggunaan metode yang tidak sesuai, serta paparan risiko hukum dan etis. Oleh karena itu, menangani CAPTCHA adalah pendekatan yang lebih andal dan berkelanjutan.

CapSolver, misalnya, adalah layanan pihak ketiga yang khusus menyelesaikan Captchas. Layanan ini menawarkan API yang dapat diintegrasikan langsung ke dalam skrip atau aplikasi pengambilan data Anda.

Dengan menugaskan penyelesaian CAPTCHA ke layanan seperti Capsolver, Anda dapat mempermudah proses pengambilan data dan mengurangi intervensi manual.

Pembatasan Kecepatan

Pembatasan kecepatan adalah metode yang digunakan situs web untuk melindungi diri dari penyalahgunaan dan berbagai jenis serangan. Metode ini menetapkan batasan pada jumlah permintaan yang dapat dibuat oleh klien dalam waktu tertentu. Jika batasnya dilampaui, situs web mungkin akan memperlambat atau memblokir permintaan menggunakan teknik seperti pemblokiran IP atau CAPTCHA.

Pembatasan kecepatan terutama fokus pada mengidentifikasi klien individu dan memantau penggunaan mereka agar tetap berada di bawah batas yang ditetapkan. Identifikasi dapat berdasarkan alamat IP klien atau menggunakan teknik seperti pemindaian sidik jari browser, yang melibatkan pengenalan fitur unik klien. String user-agent dan cookie juga mungkin diperiksa sebagai bagian dari proses identifikasi.

Solusi

Ada beberapa cara untuk mengatasi pembatasan kecepatan. Pendekatan yang sederhana adalah mengontrol frekuensi dan waktu permintaan Anda untuk meniru perilaku yang lebih manusiawi. Ini dapat mencakup penambahan jeda acak atau ulang antar permintaan. Solusi lain melibatkan rotasi alamat IP Anda dan mengcustom berbagai properti, seperti string user-agent dan sidik jari browser.

Perangkap Honeypot

Perangkap honeypot menimbulkan tantangan signifikan bagi bot pengambilan data web, karena dirancang khusus untuk menipu skrip otomatis. Perangkap ini melibatkan penambahan elemen atau tautan tersembunyi yang dimaksudkan hanya untuk diakses oleh bot.

Tujuan perangkap honeypot adalah untuk mengidentifikasi dan memblokir aktivitas pengambilan data, karena pengguna nyata tidak akan berinteraksi dengan elemen tersembunyi ini. Ketika scraper mengenai dan berinteraksi dengan perangkap-perangkap ini, hal tersebut akan memicu alarm, yang berpotensi menyebabkan scraper diblokir dari situs web.

Solusi

Untuk mengatasi tantangan ini, sangat penting untuk waspada dan menghindari jebakan honeypot. Strategi yang efektif adalah mengidentifikasi dan menghindari tautan tersembunyi. Tautan ini biasanya dikonfigurasi dengan properti CSS seperti display: none atau visibility: hidden, membuatnya tidak terlihat bagi pengguna manusia tetapi terdeteksi oleh bot pengambil data.

Dengan menganalisis struktur HTML dan properti CSS dari halaman web yang Anda ambil, Anda dapat mengecualikan atau melewati tautan tersembunyi ini. Dengan demikian, Anda dapat meminimalkan risiko memicu perangkap honeypot dan menjaga integritas serta stabilitas proses pengambilan data Anda.

Penting untuk dicatat bahwa mematuhi kebijakan dan ketentuan layanan situs web adalah penting saat melakukan aktivitas pengambilan data web. Selalu pastikan aktivitas pengambilan data Anda sesuai dengan panduan etis dan hukum yang ditetapkan oleh pemilik situs web.

Konten Dinamis

Selain pembatasan kecepatan dan pemblokiran, pengambilan data web juga menghadapi tantangan terkait mendeteksi dan menangani konten dinamis.

Situs web modern sering menggunakan sejumlah besar JavaScript untuk meningkatkan interaktivitas dan merender berbagai bagian antarmuka pengguna secara dinamis, konten tambahan, atau bahkan seluruh halaman.

Dengan populernya aplikasi halaman tunggal (SPAs), JavaScript memainkan peran penting dalam merender hampir setiap aspek situs web. Selain itu, jenis aplikasi web lainnya menggunakan JavaScript untuk memuat konten secara asinkron, memungkinkan fitur seperti infinite scroll tanpa perlu refresh atau reload halaman. Dalam kasus ini, parsing HTML saja tidak cukup.

Untuk secara sukses mengambil konten dinamis, diperlukan untuk memuat dan memproses kode JavaScript yang mendasarinya. Namun, menerapkan ini secara benar dalam skrip kustom bisa menjadi tantangan. Inilah sebabnya banyak pengembang lebih memilih menggunakan browser tanpa tampilan (headless browsers) dan alat otomasi web seperti Playwright, Puppeteer, dan Selenium.

Dengan memanfaatkan alat ini, Anda dapat meniru lingkungan browser, menjalankan JavaScript, dan mendapatkan HTML yang sepenuhnya dirender, termasuk konten yang dimuat secara dinamis. Pendekatan ini memastikan bahwa Anda menangkap semua informasi yang diinginkan, bahkan dari situs web yang sangat bergantung pada JavaScript untuk generasi konten.

Pemuatan Halaman Lambat

Ketika sebuah situs web mengalami volume permintaan yang tinggi secara bersamaan, kecepatan pemuatan halaman bisa sangat terpengaruh. Faktor-faktor seperti ukuran halaman, latensi jaringan, kinerja server, dan jumlah JavaScript serta sumber daya lain yang perlu dimuat semua berkontribusi pada masalah ini.

Pemuatan halaman yang lambat dapat menyebabkan keterlambatan dalam pengambilan data untuk pengambilan data web. Ini bisa memperlambat seluruh proyek pengambilan data, terutama ketika menangani banyak halaman. Hal ini juga bisa menyebabkan timeout, waktu pengambilan data yang tidak pasti, ekstraksi data yang tidak lengkap, atau data yang salah jika elemen halaman tertentu gagal dimuat dengan benar.

Solusi

Untuk mengatasi tantangan ini, disarankan menggunakan browser tanpa tampilan seperti Selenium atau Puppeteer. Alat-alat ini memungkinkan Anda memastikan halaman sepenuhnya dimuat sebelum mengekstrak data, menghindari informasi yang tidak lengkap atau tidak akurat. Menyetel timeout, retry, atau refresh, serta mengoptimalkan kode Anda juga dapat membantu mengurangi dampak pemuatan halaman yang lambat.

Kesimpulan

Kita menghadapi beberapa tantangan saat melakukan pengambilan data web. Tantangan-tantangan ini mencakup pemblokiran IP, verifikasi CAPTCHA, pembatasan kecepatan, perangkap honeypot, konten dinamis, dan pemuatan halaman yang lambat. Namun, kita dapat mengatasi tantangan-tantangan ini dengan menggunakan proxy, menyelesaikan CAPTCHA, mengontrol frekuensi permintaan, menghindari perangkap, memanfaatkan browser tanpa tampilan, serta mengoptimalkan kode kita. Dengan mengatasi hambatan ini, kita dapat meningkatkan upaya pengambilan data web kita, mengumpulkan informasi berharga, dan memastikan kepatuhan.

FAQ: Pertanyaan Umum tentang Tantangan Pengambilan Data Web

1. Apa itu pengambilan data web dan mengapa pentingnya?

Pengambilan data web adalah proses otomatis mengumpulkan dan mengekstrak data dari situs web. Ini banyak digunakan untuk riset pasar, pemantauan SEO, analisis data, dan pembelajaran mesin. Pengambilan data yang efisien membantu bisnis mendapatkan wawasan dan mempertahankan keunggulan kompetitif.

2. Mengapa situs web memblokir pengambil data web?

Situs web memblokir pengambil data untuk mencegah penyalahgunaan, melindungi kinerja server, dan menjaga data pribadi. Metode anti-bot umum termasuk pemblokiran IP, verifikasi CAPTCHA, dan pemindaian sidik jari JavaScript.

3. Bagaimana cara menyelesaikan CAPTCHA saat pengambilan data web?

Anda dapat menggunakan layanan penyelesaian CAPTCHA pihak ketiga seperti CapSolver. Layanan ini menyediakan API untuk menyelesaikan reCAPTCHA, hCaptcha, dan jenis CAPTCHA lainnya secara otomatis, memastikan pengumpulan data yang tidak terganggu.

4. Apa cara terbaik untuk menghindari pemblokiran IP saat mengambil data dari situs web?

Gunakan proxy yang berputar dan kendalikan kecepatan permintaan Anda. Mengirimkan terlalu banyak permintaan dalam waktu singkat dapat memicu pembatasan kecepatan atau pemblokiran. Proxy residensial dan praktik pengambilan data yang etis sangat disarankan.

5. Bagaimana cara menangani konten dinamis atau yang berbasis JavaScript?

Situs web modern sering menggunakan kerangka kerja JavaScript seperti React atau Vue, yang secara dinamis memuat konten. Alat seperti Puppeteer, Playwright, atau Selenium mensimulasikan lingkungan browser untuk merender dan mengambil data halaman penuh secara efektif.

6. Apakah ada masalah hukum atau etis dengan pengambilan data web?

Ya. Selalu patuhi Ketentuan Layanan (ToS) situs web dan hukum privasi data (seperti GDPR atau CCPA). Fokus pada data yang tersedia secara publik dan hindari pengambilan informasi sensitif atau terbatas.

7. Bagaimana cara mempercepat proyek pengambilan data web yang lambat?

Optimalkan skrip Anda dengan menyetel timeout yang tepat, menyimpan hasil, dan menggunakan permintaan asinkron. Selain itu, menyelesaikan CAPTCHA secara efisien dengan CapSolver dan menggunakan proxy yang cepat dapat mengurangi keterlambatan dan meningkatkan stabilitas.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

Cara Menyelesaikan reCAPTCHA Saat Mengambil Data Hasil Pencarian dengan Puppeteer

Menguasai seni pengambilan data web dengan Puppeteer dengan belajar cara menyelesaikan reCAPTCHA v2 dan v3 secara andal. Temukan teknik penyelesaian reCAPTCHA Puppeteer terbaik untuk pengumpulan data skala besar dan otomatisasi SEO.

Ethan Collins

06-Nov-2025

Cara Menggunakan AI untuk Pengambilan Data Web dan Menyelesaikan Captcha

Jelajahi bagaimana AI meningkatkan efisiensi web scraping dan mengotomatisasi penyelesaian CAPTCHA dengan menggunakan API berbasis AI yang kuat dari CapSolver.

Ethan Collins

05-Nov-2025

Apa Itu Pengumpulan Data: Berita Terkini tentang Pengambilan Data Web pada 2024

Pelajari semua tentang pengumpulan data — dari metode scraping web dan aplikasi dunia nyata hingga mengatasi penghalang CAPTCHA dengan CapSolver. Temukan cara untuk mengumpulkan, membersihkan, dan menganalisis data yang berharga dari situs web, dokumen, dan dataset secara efisien.

Adélia Cruz

04-Nov-2025

Cara Menyelesaikan CAPTCHA dengan Solver CAPTCHA untuk Scraping Web

Pelajari cara menggunakan API CapSolver untuk secara otomatis menyelesaikan tantangan CAPTCHA yang kompleks seperti reCAPTCHA V2 dan V3. Capai efisiensi tinggi, pengambilan data yang tidak terganggu untuk proyek scraping web Anda.

Adélia Cruz

04-Nov-2025

Solusi Terbaik Untuk Menyelesaikan Captcha Saat Scraping, Apa Itu Web Scraping?

Temukan solusi terbaik untuk menyelesaikan CAPTCHA saat melakukan scraping dan pelajari apa itu scraping web serta bagaimana cara kerjanya dalam mengotomasi pengumpulan data.

Ethan Collins

30-Oct-2025

Penyedotan Web vs API: Kumpulkan data dengan penyedotan web dan API

Pelajari perbedaan antara pengambilan data web dan APIs, kelebihan dan kekurangan mereka, serta metode mana yang paling baik untuk mengumpulkan data web yang terstruktur atau tidak terstruktur secara efisien.

Ethan Collins

29-Oct-2025