ウェブスクラピングの課題とどうやって解決するか

Sora Fujimoto

AI Solutions Architect

28-Oct-2025

インターネットは膨大なデータのリポジトリですが、その真の潜在能力を活用することは挑戦的です。構造化されていないデータの取り扱いや、ウェブサイトによって課せられる制限の乗り越え、さまざまな障害の対処など、ウェブデータを効果的にアクセスおよび利用するには、大きな課題を乗り越える必要があります。ここでのウェブ検索は非常に価値があります。非構造化されたウェブコンテンツの抽出と処理を自動化することで、貴重な洞察や競争優位性をもたらす大規模なデータセットを構築することが可能です。

しかし、ウェブデータの愛好家やプロフェッショナルは、この動的なオンライン環境で多数の課題に直面しています。この記事では、初心者とエキスパートが意識すべき上位5つのウェブ検索の課題について探求します。さらに、これらの困難を乗り越える最も効果的な解決策についても詳しく説明します。

ウェブ検索の世界をさらに深く掘り下げて、これらの課題をどう乗り越えるかを発見しましょう!

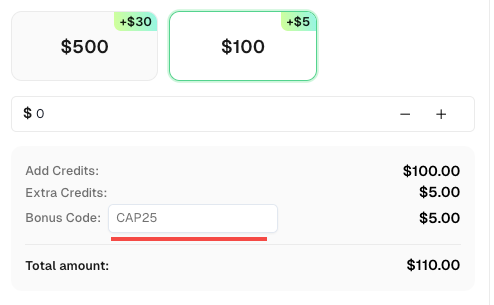

ボーナスコード

操作をさらに最適化する機会を逃さないでください!CapSolverアカウントにチャージする際、ボーナスコード CAP25 を使用して、各チャージで5%のボーナスを追加で受け取ることができます。制限はありません。CapSolverダッシュボードにアクセスして、今すぐボーナスを引き換えてください!

IPブロッキング

不正利用や未承認のウェブスクレイピングを防ぐために、ウェブサイトはIPアドレスなどのユニークな識別子に依存したブロッキング措置を取ることがあります。一定の制限を超えた場合や不審な活動が検出された場合、ウェブサイトは関連するIPアドレスをブロックし、自動スクレイピングを効果的に阻止する可能性があります。

ウェブサイトは、地理的場所に基づいてIPをブロックする地理的ブロッキングを実装することもあり、IPの発信元や異常な使用パターンを分析するその他のアンチボット対策も導入しています。

解決策

幸い、IPブロッキングを乗り越えるいくつかの解決策があります。最も簡単なアプローチは、ウェブサイトの制限に従ってリクエストを調整し、リクエストの頻度をコントロールし、自然な使用パターンを維持することです。ただし、このアプローチでは、特定の時間枠内でスクレイピングできるデータ量が大幅に制限されます。

よりスケーラブルな解決策は、IPローテーションとリトライメカニズムを備えたプロキシサービスを使用することです。プロキシやその他の回避方法を使用してウェブスクレイピングを行うことは、倫理的な懸念を引き起こす可能性があることに注意してください。常にローカルおよび国際的なデータ規制に準拠し、進む前にウェブサイトの利用規約(TOS)とポリシーを慎重に確認してください。

CAPTCHA

CAPTCHA(Completely Automated Public Turing Tests to Tell Computers and Humans Apart)は、ウェブスクレイパーがウェブサイトからデータにアクセスし抽出することを妨げる広く使用されているセキュリティメジャーです。

このシステムは、必要なコンテンツへのアクセスを許可する前にユーザーの本物性を証明するために手動のインタラクションを必要とするチャレンジを提示します。これらのチャレンジは、画像認識、テキストパズル、音声パズル、あるいはユーザー行動の分析など、さまざまな形式を取り得ます。

解決策

CAPTCHAを乗り越えるには、それらを解決するか、トリガーを回避する対策を取ることが可能です。データの整合性を確保し、自動化の効率を向上させ、信頼性と安定性を提供し、法的および倫理的なガイドラインに準拠するため、前者のアプローチを一般的に推奨します。CAPTCHAをトリガーを回避すると、データが不完全になる、手動操作が増える、非準拠の方法が使われる、法的および倫理的なリスクにさらされる可能性があります。したがって、CAPTCHAに対処することはより信頼性があり持続可能なアプローチです。

CapSolverは、例えば、CAPTCHAを解決するためのサードパーティサービスです。スクレイピングスクリプトやアプリケーションに直接統合できるAPIを提供しています。

CAPSolverなどのサービスにCAPTCHAの解決をアウトソーシングすることで、スクレイピングプロセスをスムーズにし、手動の介入を減らすことができます。

レートリミット

レートリミットは、ウェブサイトが不正利用やさまざまな種類の攻撃を防ぐために使用する方法です。これは、一定の時間枠内でクライアントが行うリクエストの数に制限を設けるものです。制限を超えると、ウェブサイトはIPブロッキングやCAPTCHAを使用してリクエストをスロットルまたはブロックする可能性があります。

レートリミットは主に個々のクライアントを特定し、使用状況を監視して設定された制限内で保つことを目的としています。クライアントのIPアドレスに基づいて識別されることがあり、ブラウザのファイントラッキングなどの技術を用いることもあります。ユーザーエージェント文字列やクッキーも識別プロセスの一部として検討されることがあります。

解決策

レートリミットを乗り越える方法はいくつかあります。簡単なアプローチは、リクエストの頻度とタイミングを制御して、より人間らしい行動を模倣することです。これには、リクエスト間のランダムな遅延やリトライを導入することが含まれます。他の解決策には、IPアドレスをローテーションし、ユーザーエージェント文字列やブラウザファイントラッキングなどのさまざまなプロパティをカスタマイズすることが含まれます。

ハニーポットトラップ

ハニーポットトラップは、ウェブスクレイピングボットにとって大きな課題であり、自動スクリプトをだますように設計されています。これらのトラップは、ボットのみがアクセスするように設計された隠し要素やリンクを含んでいます。

ハニーポットトラップの目的は、スクレイピング活動を識別してブロックすることです。実際のユーザーはこれらの隠し要素にインタラクションしないからです。スクリーパーがこれらのトラップに遭遇し、インタラクションすると、赤信号が点灯し、ウェブサイトからスクリーパーがブロックされる可能性があります。

解決策

この課題を乗り越えるために、ハニーポットトラップに陥らないように注意深くすることが重要です。効果的な戦略の一つは、隠しリンクを識別し回避することです。これらのリンクは通常、display: noneやvisibility: hiddenなどのCSSプロパティで構成されており、人間のユーザーには見えませんが、スクレイピングボットには検出可能です。

スクレイピングしているウェブページのHTML構造とCSSプロパティを注意深く分析することで、これらの隠しリンクを除外または回避できます。これにより、ハニーポットトラップをトリガーするリスクを最小限に抑え、スクレイピングプロセスの整合性と安定性を維持できます。

ウェブスクレイピング活動において、ウェブサイトのポリシーや利用規約を尊重することが重要です。常にウェブサイトの所有者が設定した倫理的および法的ガイドラインに準拠していることを確認してください。

ダイナミックコンテンツ

レートリミットやブロッキングに加え、ウェブスクレイピングには動的コンテンツの検出と処理に関する課題もあります。

現代のウェブサイトは、インタラクティブ性を高め、ユーザーインターフェースのさまざまな部分、追加のコンテンツ、または完全なページを動的にレンダリングするために、JavaScriptを多く使用しています。

シングルページアプリケーション(SPA)の普及に伴い、JavaScriptはウェブサイトのほぼすべての側面をレンダリングする重要な役割を果たしています。また、他の種類のウェブアプリケーションは、JavaScriptを使用して非同期にコンテンツを読み込み、ページのリロードやリフレッシュなしで無限スクロールなどの機能を可能にしています。このような場合、HTMLを解析するだけでは不十分です。

動的コンテンツを成功裏にスクレイピングするには、下位のJavaScriptコードをロードおよび処理する必要があります。しかし、カスタムスクリプトでこれを正しく実装するのは難しい場合があります。そのため、多くの開発者は、Playwright、Puppeteer、Seleniumなどのヘッドレスブラウザとウェブ自動化ツールを好む傾向があります。

これらのツールを活用することで、ブラウザ環境をエミュレートし、JavaScriptを実行し、動的に読み込まれたコンテンツを含む完全にレンダリングされたHTMLを取得できます。このアプローチにより、JavaScriptに依存してコンテンツを生成するウェブサイトからも必要な情報をすべて取得できます。

遅いページロード

ウェブサイトが多数の同時リクエストを処理する場合、ロード速度が大幅に影響を受けることがあります。ページのサイズ、ネットワークの遅延、サーバーのパフォーマンス、ロードするJavaScriptやその他のリソースの量などがこの問題に寄与します。

ページロードが遅いと、ウェブスクレイピングにおけるデータ取得に遅延が生じます。これは、複数のページを扱う場合、全体的なスクレイピングプロジェクトを遅らせる可能性があります。タイムアウト、予測できないスクレイピング時間、不完全なデータ抽出、または一部のページ要素が正しく読み込まれない場合の誤ったデータを引き起こす可能性があります。

解決策

この課題に対処するには、SeleniumやPuppeteerなどのヘッドレスブラウザを使用することが推奨されます。これらのツールを使用すると、データを抽出する前にページが完全に読み込まれていることを確認できます。タイムアウトやリトライ、リフレッシュの設定、コードの最適化も、遅いページロードの影響を軽減するのに役立ちます。

結論

ウェブスクレイピングにはいくつかの課題があります。これらの課題には、IPブロッキング、CAPTCHA検証、レートリミット、ハニーポットトラップ、ダイナミックコンテンツ、遅いページロードが含まれます。しかし、プロキシの使用、CAPTCHAの解決、リクエスト頻度の制御、トラップの回避、ヘッドレスブラウザの活用、コードの最適化によってこれらの課題を乗り越えることができます。これらの障壁に対処することで、ウェブスクレイピングの取り組みを改善し、貴重な情報を収集し、準拠を確保できます。

FAQ: ウェブスクレイピングの課題に関する一般的な質問

1. ウェブスクレイピングとは何ですか?なぜ重要ですか?

ウェブスクレイピングは、ウェブサイトからデータを収集および抽出する自動化されたプロセスです。これは、マーケットリサーチ、SEOトラッキング、データ分析、機械学習に広く使用されています。効率的なスクレイピングは、企業が洞察を得て競争優位を維持するのに役立ちます。

2. なぜウェブサイトはウェブスクレイパーをブロックするのですか?

ウェブサイトは、不正利用の防止、サーバーのパフォーマンスの保護、プライベートデータのセキュリティを確保するためにスクレイパーをブロックします。一般的なアンチボット方法には、IPブロッキング、CAPTCHA検証、JavaScriptファイントラッキングが含まれます。

3. ウェブスクレイピング中にCAPTCHAをどうやって解決しますか?

**CapSolver**などのサードパーティのCAPTCHA解決サービスを使用できます。これは、reCAPTCHA、hCaptcha、その他のCAPTCHAタイプを自動的に解決するAPIを提供し、データ収集をスムーズに行うことを保証します。

4. ウェブサイトをスクレイピングする際、IPブロッキングをどうやって回避しますか?

ローテーションプロキシを使用し、リクエストの頻度を制御することが最善の方法です。短期間で多すぎるリクエストを送信すると、レートリミットやブロックがトリガーされる可能性があります。住宅用プロキシと倫理的なスクレイピングの実践が強く推奨されます。

5. ダイナミックまたはJavaScriptが豊富なコンテンツをどうやって扱いますか?

現代のウェブサイトは、ReactやVueなどのJavaScriptフレームワークを多く使用しており、コンテンツを動的に読み込みます。Puppeteer、Playwright、またはSeleniumなどのツールは、ブラウザ環境をシミュレートし、完全なページデータを効果的にレンダリングおよびスクレイピングできます。

6. ウェブスクレイピングには法的または倫理的な懸念がありますか?

はい。常にウェブサイトの**利用規約(ToS)**とデータプライバシー法(GDPRやCCPAなど)に準拠してください。公開されているデータに焦点を当て、機密情報や制限付き情報のスクレイピングを避けてください。

7. 遅いウェブスクレイピングプロジェクトをどうやって高速化しますか?

スクリプトを最適化し、適切なタイムアウトを設定し、結果をキャッシュし、非同期リクエストを使用してください。また、CapSolverでCAPTCHAを効率的に解決し、高速なプロキシを使用することで、遅延を短縮し、安定性を向上させることができます。

コンプライアンス免責事項: このブログで提供される情報は、情報提供のみを目的としています。CapSolverは、すべての適用される法律および規制の遵守に努めています。CapSolverネットワークの不法、詐欺、または悪用の目的での使用は厳格に禁止され、調査されます。私たちのキャプチャ解決ソリューションは、公共データのクローリング中にキャプチャの問題を解決する際に100%のコンプライアンスを確保しながら、ユーザーエクスペリエンスを向上させます。私たちは、サービスの責任ある使用を奨励します。詳細については、サービス利用規約およびプライバシーポリシーをご覧ください。

もっと見る

Puppeteerで検索結果をスクレイピングする際のreCAPTCHAの回避方法

Puppeteerでのウェブスクレイピングをマスターし、reCAPTCHA v2およびv3を信頼性のある方法で解く方法を学びましょう。大規模なデータ収集およびSEO自動化に最適なPuppeteerのreCAPTCHAソルバーテクニックを発見してください。

Adélia Cruz

06-Nov-2025

AIをウェブスクレイピングとCaptchaを解決する方法

AIがウェブスクラッピングの効率を向上させ、CapSolverの強力なAIベースのAPIでCAPTCHAの解決を自動化する方法を調べてみましょう。

Sora Fujimoto

05-Nov-2025

ECサイトをスクレイピングする際のキャプチャの解決方法

CapSolverのImageToText APIの使い方を学んで、ECサイト上のCAPTCHAチャレンジを自動で解き、高効率で安定し、途切れのないデータ抽出を実現しましょう。

Nikolai Smirnov

05-Nov-2025

データハーベスティングとは?: 2024年のウェブスクレイピングに関する最新ニュース

データ収集についてすべて学ぶ – ウェブスクリーピングの方法や実際の応用から、CapSolverを使用してCAPTCHAの障壁を乗り越える方法まで。ウェブサイト、ドキュメント、データセットから価値のあるデータを効率的に収集、整備、分析する方法を学びましょう。

Sora Fujimoto

04-Nov-2025

ウェブスクラピング用のCAPTCHAソルバーでCAPTCHAを解く方法

CapSolverのAPIを使用して、reCAPTCHA V2やV3などの複雑なCAPTCHAチャレンジを自動で解決する方法を学びましょう。ウェブスクリーピングプロジェクトで高効率かつ中断することのないデータ抽出を実現しましょう。

Sora Fujimoto

04-Nov-2025

2026年最佳キャプチャ解決サービス、どのキャプチャサービスが最適ですか?

2026年の最高のCAPTCHA解決サービスを比較する。キャプソルバーの先進的なAI技術の優位性を発見:スピード、99%以上の精度、キャプチャーチャレンジとの互換性。

Sora Fujimoto

30-Oct-2025