Top 5 Casos de Uso de Web Scraping para Automação, Aprendizado de Máquina e Insights Empresariais

Adélia Cruz

Neural Network Developer

17-Oct-2025

Na esteira da revolução digital, os dados tornaram-se o ativo mais valioso para uma empresa. O Web Scraping, a tecnologia-chave para adquirir de forma eficiente grandes volumes de informações públicas da internet, está se tornando cada vez mais o alicerce para impulsionar a automação de negócios, capacitar modelos de aprendizado de máquina e aprofundar insights comerciais. Ele já não é apenas uma ferramenta técnica, mas uma capacidade estratégica crítica para as empresas obterem uma vantagem competitiva e permitirem decisões em tempo real.

Este artigo abordará as cinco aplicações principais do web scraping nos três domínios estratégicos de "Automação", "Aprendizado de Máquina" e "Insights de Negócios". Ofereceremos insights únicos e conselhos práticos para ajudar as empresas a superarem seus concorrentes e construírem um negócio de alto valor baseado em dados.

I. Web Scraping: Um Salto da Tecnologia para a Estratégia

Métodos tradicionais de pesquisa de mercado e coleta de dados são frequentemente demorados, caros e carecem de capacidade em tempo real. O web scraping, usando programas automatizados (crawlers) para simular o comportamento de navegação humano e extrair dados estruturados de páginas da web, aumenta significativamente a eficiência e a escala da coleta de dados.

Três Valores Estratégicos do Web Scraping:

- Automação: Delegar tarefas repetitivas e demoradas de coleta de dados para máquinas, liberando recursos humanos para se concentrarem em análise e tomada de decisão.

- Aprendizado de Máquina: Fornecer conjuntos de dados de treinamento de grande escala, de alta qualidade e personalizados para modelos de IA complexos — o sangue do desempenho do modelo.

- Insights de Negócios: Oferecer uma visão em tempo real e abrangente do mercado, apoiando estratégias de precificação dinâmica, análise de concorrência e previsão de tendências.

II. Análise Detalhada de Cinco Cenários de Aplicação Principais

Focaremos nos cinco cenários de aplicação mais impactantes, que são práticas comuns na indústria e também fundamentais para alcançar competição diferenciada.

1. Potencializando Modelos de Aprendizado de Máquina: "Pipeline de Dados" para Dados de Treinamento de Alta Qualidade

Na era da Inteligência Artificial, a verdade de que "os dados determinam o limite superior de um modelo" é amplamente aceita. O web scraping é o método mais eficaz para construir conjuntos de dados de treinamento de alta qualidade e personalizados.

| Desafio | Solução de Web Scraping | Valor Único e Insight |

|---|---|---|

| Conjuntos de dados públicos estão desatualizados ou irrelevantes | Coleta em tempo real de dados específicos do domínio, garantindo frescor e relevância dos dados. | Geração de Etiquetas Personalizadas: Ao coletar avaliações, tags ou informações de classificação de sites específicos, rótulos mais granulares podem ser gerados automaticamente para os dados, superando significativamente a granularidade dos conjuntos de dados gerais. |

| Volume insuficiente de dados | Coleta escalável de textos, imagens, metadados de vídeo, etc., para construir rapidamente conjuntos de dados com milhões de registros. | Fusão de Dados Multimodais: Além de textos, coletar também descrições de imagens associadas e dados de interação do usuário, para treinar modelos de IA mais complexos que operam com múltiplos modos. |

| Viés nos dados | Coletar dados de múltiplas fontes diferentes para validação cruzada e equilíbrio, reduzindo o viés dos dados provenientes de uma única fonte. | Monitoramento de Desvio de Dados: Coletar dados continuamente e compará-los com os dados de treinamento do modelo para detectar mudanças na distribuição de dados (desvio de dados) de forma oportuna, orientando o re-treinamento do modelo. |

【Dica Prática】: Ao coletar dados para modelos de ML, o processo de limpeza e estruturação dos dados deve ser considerado um componente central do pipeline de scraping, garantindo a uniformidade do formato dos dados e a precisão das etiquetas.

2. Monitoramento em Tempo Real de Preços Competitivos e Estratégia de Precificação Dinâmica

Nos setores de comércio eletrônico e varejo, o preço é o fator mais direto que influencia as decisões de compra dos consumidores. O web scraping permite monitoramento em milissegundos dos preços, estoque e atividades promocionais dos concorrentes, apoiando assim estratégias de Precificação Dinâmica.

Ao coletar continuamente os preços dos SKUs (Unidades de Controle de Estoque), informações de descontos e status de estoque dos principais concorrentes, as empresas podem alimentar esses dados em seus algoritmos de precificação. Modelos de aprendizado de máquina podem, então, ajustar os preços dos produtos em tempo real com base na elasticidade da demanda, movimentos dos concorrentes e dados históricos de vendas, maximizando lucro ou participação de mercado.

【Valor Diferenciado】: Além dos preços, coletar "Histórico de Mudanças de Preço" e "Estratégias de Venda em Pacotes" fornece insights mais profundos. Por exemplo, analisar a magnitude das mudanças de preço de um concorrente durante feriados específicos pode prever seu comportamento de marketing futuro.

3. Análise de Sentimento de Mercado e Gestão da Reputação da Marca

Redes sociais, fóruns, sites de notícias e seções de avaliações de comércio eletrônico contêm uma vasta quantidade de dados de sentimento dos consumidores. Ao coletar esse texto não estruturado e combiná-lo com a tecnologia de Processamento de Linguagem Natural (NLP), as empresas podem realizar uma Análise de Sentimento em Grande Escala.

- Insights de Negócios: Compreender instantaneamente o feedback do mercado após o lançamento de um novo produto, identificando rapidamente defeitos do produto ou pontos de dor nos serviços.

- Automação: Identificar automaticamente comentários negativos e sinais de crise, acionando um sistema de alerta antecipado para gestão automatizada da reputação da marca.

【Insight Único】: A granularidade da análise de sentimento deve ser refinada do nível "produto" para o nível "característica do produto". Por exemplo, ao coletar avaliações de um telefone celular, analisar o sentimento não apenas do produto como um todo, mas também de palavras-chave específicas como "vida da bateria" e "desempenho da câmera" para orientar a melhoria do produto.

4. Geração Automática de Leads e Expansão de Mercado

Para empresas B2B, encontrar clientes potenciais e parceiros de mercado é essencial para o crescimento sustentável. O web scraping pode automatizar esse processo tedioso.

Ao coletar dados de diretórios industriais, listas corporativas, placas de empregos e plataformas sociais profissionais, um banco de dados de clientes-alvo pode ser construído, incluindo nomes de empresas, contatos, cargos, tecnologias utilizadas e tamanho da empresa.

【Dica Prática】: Combinar isso com as soluções de CAPTCHA mencionadas nos links internos pode ser mais eficaz para combater mecanismos anti-scraping de sites-alvo, garantindo a continuidade e a precisão dos dados de leads. Por exemplo, usar uma ferramenta como CapSolver para resolver desafios complexos de AWS WAF ou reCAPTCHA garante que o processo de scraping automatizado não seja interrompido.

Leitura Adicional: Resolver desafios complexos de CAPTCHA é um passo crítico na obtenção de leads de vendas de alta qualidade. Saiba mais sobre as informações de resolução de CAPTCHA da AWS WAF e reCAPTCHA v2/v3.

5. Inteligência de Mercado Financeiro e Previsão de Risco

A indústria financeira exige padrões extremamente altos em capacidade de dados em tempo real e precisão. O web scraping desempenha um papel irreplaceável na inteligência financeira, negociação algorítmica e gestão de risco.

- Insights de Negócios: Coletar relatórios em tempo real de agências de notícias, anúncios regulatórios e discussões financeiras nas redes sociais para construir estratégias de negociação baseadas em eventos.

- Aprendizado de Máquina: Treinar modelos para identificar indicadores de sentimento e índices de incerteza dentro de textos de notícias para prever flutuações curtas no preço das ações.

【Valor Diferenciado】: Além de coletar dados financeiros tradicionais, coletar dados da cadeia de suprimentos (como informações públicas sobre rastreamento de envios e status de produção de fábricas) pode fornecer sinais macroeconômicos iniciais para decisões de investimento — uma vantagem única que fontes tradicionais de dados financeiros frequentemente não possuem.

III. Comparação de Seleção de Tecnologia de Web Scraping: Eficiência vs. Mecanismos Anti-Bot

Escolher a pilha de tecnologia certa é crucial ao implementar um projeto de web scraping. Abaixo está uma comparação de métodos de scraping principais em termos de eficiência, capacidade anti-bot e custo:

| Funcionalidade | Crawler Construído por Si Mesmo (ex.: Python/Scrapy) | Serviço Comercial de Scraping (ex.: Scraping API) | Navegador Sem Cabeça (ex.: Puppeteer/Playwright) |

|---|---|---|---|

| Custo de Desenvolvimento | Alto (Requer lidar com todos os detalhes) | Baixo (Chamada de API, integração rápida) | Médio (Requer lidar com ambiente do navegador e consumo de recursos) |

| Eficiência de Scraping | Extremamente Alta (Otimizado para objetivos específicos) | Alta (O provedor gerencia a manutenção) | Inferior (Alto consumo de recursos, velocidade mais lenta) |

| Capacidade Anti-Bot | Alta (Estratégias anti-bot personalizáveis) | Extremamente Alta (Equipe profissional gerencia pool de proxies e fingerprinting) | Média (Simula comportamento de navegador real) |

| Dificuldade de Manutenção | Extremamente Alta (Atualizações frequentes necessárias para mudanças na estrutura do site) | Baixa (Provedor gerencia a manutenção) | Média (Atualizações do navegador e configuração do ambiente) |

| Caso de Uso Ideal | Projetos de longo prazo, de grande escala e altamente personalizados | Necessidades comerciais rápidas, estáveis e de alta concorrência | Cenários que exigem execução complexa de JavaScript ou login |

【Insight Único】: Para aplicações comerciais que exigem alta eficiência e forte capacidade anti-bot, um serviço comercial de scraping geralmente é a escolha mais rentável, pois terceiriza o trabalho complexo de gerenciamento de proxies e manutenção anti-bot para uma equipe especializada.

IV. Desafios e Contramedidas na Implementação de Web Scraping

Embora o web scraping tenha um grande potencial, sua operação prática ainda enfrenta diversos desafios, especialmente em cenários que envolvem coleta de dados em grande escala e alta frequência.

Desafio 1: Aumento dos Mecanismos Anti-Bot

Mecanismos anti-bot de sites estão se tornando cada vez mais sofisticados, variando de bloqueio de IP simples a análise de comportamento complexa, fingerprinting TLS e desafios CAPTCHA.

Contramedidas:

- Usar Serviços de Proxy de Alta Qualidade: Combinar proxies residenciais ou de datacenter para rotacionar IPs e evitar bloqueios.

- Simular Comportamento de Usuário Real: Usar navegadores sem cabeça para simular movimentos do mouse, rolagem e cliques, e modificar parâmetros como User-Agent e Headers para imitar um usuário comum.

- Integrar Soluções de CAPTCHA: Para desafios como reCAPTCHA, clouflare ou CAPTCHA da AWS WAF, integrar serviços terceirizados profissionais de resolução de CAPTCHA (como CapSolver) para superar automaticamente os obstáculos.

Desafio 2: Limites Legais e Éticos

A coleta de dados deve seguir leis, regulamentos e os Termos de Serviço do site.

Contramedidas:

- Coletar apenas dados públicos: Evitar estritamente coletar dados pessoais privados ou dados que exigem acesso de login.

- Cumprir o Protocolo robots.txt: Verificar o arquivo

robots.txtdo site-alvo antes de coletar dados e respeitar as restrições estabelecidas pelo proprietário. - Controlar a Frequência da Coleta: Definir intervalos de solicitação razoáveis para evitar sobrecarregar os servidores do site-alvo.

V. Conclusão e Perspectiva

O web scraping é uma parte indispensável da estratégia de negócios baseada em dados de uma empresa moderna. Ao aplicá-lo em áreas principais como geração de dados de treinamento para IA, precificação dinâmica, análise de sentimento de mercado, geração automatizada de leads e inteligência financeira, as empresas podem obter insights comerciais precisos e em tempo real, mantendo uma vantagem competitiva.

Uma estratégia de web scraping bem-sucedida não reside apenas em avanços tecnológicos, mas também no cumprimento de regulamentações legais, respeito à ética dos dados e adaptação contínua aos desafios anti-bot. Com o desenvolvimento contínuo da tecnologia de IA, o web scraping futuro será mais inteligente e adaptável, trazendo profundidade e amplitude sem precedentes para a tomada de decisões empresariais.

Apêndice: Perguntas Frequentes (FAQ)

Q1: O web scraping é legal?

A1: A legalidade do web scraping depende do conteúdo específico e do método de coleta. Geralmente, coletar dados acessíveis publicamente (não de login, não privados) é legal. No entanto, você deve seguir estritamente o protocolo robots.txt do site-alvo e seus Termos de Serviço. Coletar conteúdo com direitos autorais ou dados pessoais privados é ilegal. É aconselhável consultar profissionais legais e sempre realizar a coleta de dados de forma responsável e ética.

Q2: Os dados coletados podem ser usados diretamente para modelos de aprendizado de máquina?

A2: Geralmente, não. Dados brutos coletados frequentemente contêm ruído significativo, valores ausentes, formatos inconsistentes e outros problemas. Antes de serem usados em modelos de aprendizado de máquina, devem passar por etapas rigorosas de pré-processamento, como Limpeza de Dados, Transformação de Dados e Engenharia de Características, para garantir a qualidade dos dados e a precisão do modelo.

Q3: Qual a diferença entre web scraping e chamadas de API?

A3: Uma API (Interface de Programação de Aplicações) é uma interface oficial fornecida proativamente por um site ou serviço para obter dados estruturados; é estável, eficiente e legal. O web scraping extrai dados do conteúdo HTML de um site e é usado quando uma API não está disponível ou sua funcionalidade é limitada. Sempre que possível, priorize o uso da API; considere o web scraping apenas quando a API não estiver disponível ou for insuficiente para suas necessidades.

Q4: Como o CapSolver ajuda com os problemas de CAPTCHA no web scraping?

A4: CapSolver é um serviço profissional de resolução automática de CAPTCHA. Ele utiliza tecnologia avançada de IA e aprendizado de máquina para reconhecer e resolver automaticamente diversos tipos complexos de CAPTCHA, como reCAPTCHA v2/v3, Cloudflare e CAPTCHA da AWS WAF, entre outros. Ao integrar a API do CapSolver ao seu fluxo de scraping, você pode obter coleta de dados automatizada sem interrupções, superando efetivamente os obstáculos de CAPTCHA nos mecanismos anti-bot.

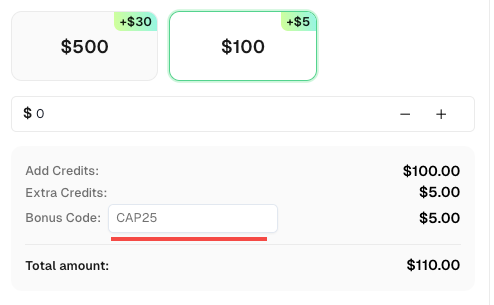

Resgate seu código de bônus do CapSolver

Não perca a oportunidade de otimizar ainda mais suas operações! Use o código de bônus CAP25 ao recarregar sua conta do CapSolver e receba um bônus extra de 5% em cada recarga, sem limites. Acesse o Painel do CapSolver para resgatar seu bônus agora!

Q6: Como posso garantir que meu web scraping seja sustentável (ou seja, não quebre devido a mudanças na estrutura do site)?

A6: Mudanças na estrutura do site são uma das maiores dificuldades para raspagem. As contramedidas incluem:

- Use uma combinação de seletores CSS ou XPath: Não dependa de um único seletor excessivamente específico.

- Estabeleça um sistema de monitoramento e alerta: Verifique regularmente o status da raspagem dos pontos-chave de dados e levante um alerta imediatamente se a raspagem falhar.

- Use ferramentas de raspagem impulsionadas por IA: Algumas ferramentas avançadas (como os Raspadores Baseados em Prompt mencionados no link interno) podem usar IA para se adaptar a mudanças menores na estrutura do site, reduzindo os custos de manutenção.

Declaração de Conformidade: As informações fornecidas neste blog são apenas para fins informativos. A CapSolver está comprometida em cumprir todas as leis e regulamentos aplicáveis. O uso da rede CapSolver para atividades ilegais, fraudulentas ou abusivas é estritamente proibido e será investigado. Nossas soluções de resolução de captcha melhoram a experiência do usuário enquanto garantem 100% de conformidade ao ajudar a resolver dificuldades de captcha durante a coleta de dados públicos. Incentivamos o uso responsável de nossos serviços. Para mais informações, visite nossos Termos de Serviço e Política de Privacidade.

Mais

Como resolver o reCAPTCHA ao raspar resultados de pesquisa com o Puppeteer

Domine a arte da raspagem de web com o Puppeteer aprendendo a resolver de forma confiável o reCAPTCHA v2 e v3. Descubra as melhores técnicas para solucionar reCAPTCHA com o Puppeteer para coleta de dados em grande escala e automação de SEO.

Adélia Cruz

06-Nov-2025

Como usar IA para scraping na web e resolvendo Captcha

Explore como a IA melhora a eficiência da raspagem de web e automatiza a resolução de CAPTCHA usando a poderosa API baseada em IA do CapSolver.

Adélia Cruz

05-Nov-2025

Como resolver Captchas ao raspar sites de comércio eletrônico

Aprenda como usar a API ImageToText da CapSolver para resolver automaticamente os desafios CAPTCHA em sites de comércio eletrônico. Alcance alta eficiência, estabilidade e extração de dados ininterrupta.

Aloísio Vítor

05-Nov-2025

O que é Coleta de Dados: Últimas Notícias sobre Raspagem da Web em 2024

Aprenda tudo sobre coleta de dados — dos métodos de raspagem da web e aplicações do mundo real até superar barreiras CAPTCHA usando o CapSolver. Descubra como coletar, limpar e analisar dados valiosos de sites, documentos e conjuntos de dados de forma eficiente.

Adélia Cruz

04-Nov-2025

Como resolver CAPTCHA com o Captcha Solver para raspagem de web

Aprenda como usar a API do CapSolver para resolver automaticamente desafios de CAPTCHA complexos, como reCAPTCHA V2 e V3. Obtenha extração de dados eficiente e ininterrupta para seus projetos de raspagem de web.

Adélia Cruz

04-Nov-2025

Melhor Serviço de Resolução de Captcha 2026, Qual Serviço CAPTCHA é o Melhor?

Compare os melhores serviços de resolução de CAPTCHA para 2026. Descubra a vantagem da IA de ponta do CapSolver em velocidade, precisão de 99%+ e compatibilidade com Captcha Challenge

Adélia Cruz

30-Oct-2025