Desafios do Web Scraping e Como Resolvê-lo

Adélia Cruz

Neural Network Developer

28-Oct-2025

A internet é um repositório vasto de dados, mas aproveitar seu verdadeiro potencial pode ser desafiador. Seja lidando com dados em formato não estruturado, navegando por limitações impostas pelos sites ou enfrentando diversos obstáculos, acessar e utilizar dados da web efetivamente exige superar grandes barreiras. É aí que a busca na web se torna valiosa. Ao automatizar a extração e o processamento de conteúdo da web não estruturado, é possível compilar conjuntos de dados extensos que oferecem insights valiosos e uma vantagem competitiva.

No entanto, entusiastas e profissionais de dados da web enfrentam diversos desafios nesse ambiente online dinâmico. Neste artigo, exploraremos os 5 principais desafios de busca na web que iniciantes e especialistas devem estar cientes. Além disso, vamos aprofundar as soluções mais eficazes para superar essas dificuldades.

Vamos mergulhar mais fundo no mundo da busca na web e descobrir como superar esses desafios!

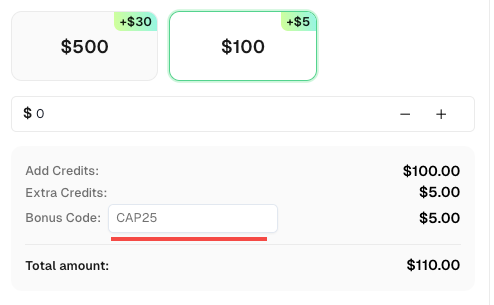

Código Bônus

Não perca a oportunidade de otimizar ainda mais suas operações! Use o código bônus CAP25 ao recarregar sua conta no CapSolver e receba um bônus adicional de 5% em cada recarga, sem limites. Acesse o Painel do CapSolver para resgatar seu bônus agora!

Bloqueio de IP

Para impedir abuso e raspagem de web não autorizada, os sites frequentemente utilizam medidas de bloqueio que dependem de identificadores únicos como endereços IP. Quando certos limites são ultrapassados ou atividades suspeitas são detectadas, o site pode banir o endereço IP associado, efetivamente impedindo a raspagem automatizada.

Os sites também podem implementar geo-bloqueio, que bloqueia IPs com base em sua localização geográfica, bem como outras medidas anti-bot que analisam a origem do IP e padrões de uso incomuns para identificar e bloquear IPs.

Solução

Felizmente, existem várias soluções para superar o bloqueio de IP. A abordagem mais simples envolve ajustar suas solicitações para seguir os limites do site, controlar a frequência das solicitações e manter um padrão de uso natural. No entanto, essa abordagem restringe significativamente a quantidade de dados que podem ser raspados em um determinado período de tempo.

Uma solução mais escalável é utilizar um serviço de proxy que inclua rotação de IP e mecanismos de tentativa de novo para evitar o bloqueio de IP. É importante notar que a raspagem de web usando proxies e outros métodos de contornar pode levantar preocupações éticas. Sempre certifique-se de estar em conformidade com as regulamentações locais e internacionais de dados e revise cuidadosamente os termos de serviço (TOS) e políticas do site antes de prosseguir.

CAPTCHAs

CAPTCHAs, sigla para Testes de Turing Públicos Automatizados para Distinguir Computadores e Humanos, servem como uma medida de segurança amplamente utilizada para impedir que raspadores de web acessem e extraiam dados de sites.

Este sistema apresenta desafios que exigem interação manual para provar a autenticidade do usuário antes de conceder acesso ao conteúdo desejado. Esses desafios podem assumir várias formas, incluindo reconhecimento de imagens, quebra-cabeças textuais, quebra-cabeças auditivos ou até mesmo análise de comportamento do usuário.

Solução

Para superar CAPTCHAs, é possível resolvê-los ou tomar medidas para evitar acioná-los. Geralmente, é recomendado optar pela primeira abordagem, pois garante a integridade dos dados, aumenta a eficiência da automação, fornece confiabilidade e estabilidade, e está em conformidade com diretrizes legais e éticas. Evitar acionar CAPTCHA pode resultar em dados incompletos, operações manuais aumentadas, uso de métodos não compatíveis e exposição a riscos legais e éticos. Portanto, abordar CAPTCHA é uma abordagem mais confiável e sustentável.

CapSolver, por exemplo, é um serviço terceirizado dedicado à resolução de Captchas. Ele oferece uma API que pode ser integrada diretamente em scripts de raspagem ou aplicações.

Ao terceirizar a resolução de CAPTCHA para serviços como Capsolver, você pode otimizar o processo de raspagem e reduzir a intervenção manual.

Limitação de Taxa

Limitação de taxa é um método empregado pelos sites para proteger contra abuso e diferentes tipos de ataques. Ele estabelece limites no número de solicitações que um cliente pode fazer em um determinado período de tempo. Se o limite for ultrapassado, o site pode limitar ou bloquear as solicitações usando técnicas como bloqueio de IP ou CAPTCHA.

A limitação de taxa se concentra principalmente em identificar clientes individuais e monitorar seu uso para garantir que fiquem dentro dos limites estabelecidos. A identificação pode ser baseada no endereço IP do cliente ou utilizar técnicas como identificação de navegador, que envolvem a detecção de características únicas do cliente. Strings de user-agent e cookies também podem ser analisadas como parte do processo de identificação.

Solução

Existem várias formas de superar limitações de taxa. Uma abordagem simples é controlar a frequência e o horário de suas solicitações para imitar um comportamento mais humano. Isso pode incluir a introdução de atrasos aleatórios ou tentativas de novo entre solicitações. Outras soluções envolvem a rotação do seu endereço IP e a personalização de várias propriedades, como a string de user-agent e a identificação de navegador.

Armadilhas de Honeypot

Armadilhas de Honeypot representam um desafio significativo para bots de raspagem de web, pois são especificamente projetadas para enganar scripts automatizados. Essas armadilhas envolvem a inclusão de elementos ou links ocultos que são destinados a serem acessados apenas por bots.

O propósito das armadilhas de Honeypot é identificar e bloquear atividades de raspagem, pois usuários reais não interagem com esses elementos ocultos. Quando um raspador encontra e interage com essas armadilhas, ele aciona um alerta, potencialmente levando ao banimento do raspador do site.

Solução

Para superar esse desafio, é crucial estar atento e evitar cair em armadilhas de Honeypot. Uma estratégia eficaz é identificar e evitar links ocultos. Esses links geralmente são configurados com propriedades CSS como display: none ou visibility: hidden, tornando-os invisíveis para usuários humanos, mas detectáveis pelos bots de raspagem.

Ao analisar cuidadosamente a estrutura HTML e as propriedades CSS das páginas da web que você está raspando, você pode excluir ou contornar esses links ocultos. Dessa forma, você pode minimizar o risco de acionar armadilhas de Honeypot e manter a integridade e a estabilidade do seu processo de raspagem.

É importante ressaltar que respeitar as políticas e termos de serviço do site é essencial ao realizar atividades de raspagem de web. Sempre certifique-se de que suas atividades de raspagem estejam alinhadas com as diretrizes éticas e legais estabelecidas pelos proprietários do site.

Conteúdo Dinâmico

Além da limitação de taxa e bloqueio, a raspagem de web apresenta desafios relacionados à detecção e tratamento de conteúdo dinâmico.

Sites modernos frequentemente incorporam uma quantidade significativa de JavaScript para melhorar a interatividade e renderizar dinamicamente partes da interface do usuário, conteúdo adicional ou até mesmo páginas inteiras.

Com a prevalência de aplicações de página única (SPAs), o JavaScript desempenha um papel crucial no renderização de quase todos os aspectos do site. Além disso, outros tipos de aplicações web utilizam JavaScript para carregar conteúdo de forma assíncrona, permitindo recursos como rolagem infinita sem a necessidade de recarregar a página. Nesses casos, analisar apenas o HTML não é suficiente.

Para raspagem bem-sucedida de conteúdo dinâmico, é necessário carregar e processar o código JavaScript subjacente. No entanto, implementar isso corretamente em um script personalizado pode ser desafiador. Por isso, muitos desenvolvedores preferem utilizar navegadores headless e ferramentas de automação da web, como Playwright, Puppeteer e Selenium.

Ao utilizar essas ferramentas, você pode simular um ambiente de navegador, executar JavaScript e obter o HTML totalmente renderizado, incluindo qualquer conteúdo carregado dinamicamente. Essa abordagem garante que você capture todas as informações desejadas, mesmo em sites que dependem fortemente do JavaScript para gerar conteúdo.

Carregamento Lento de Página

Quando um site enfrenta um volume elevado de solicitações simultâneas, sua velocidade de carregamento pode ser significativamente afetada. Fatores como o tamanho da página, latência da rede, desempenho do servidor e a quantidade de JavaScript e outros recursos a serem carregados contribuem para esse problema.

O carregamento lento de página pode causar atrasos na recuperação de dados para raspagem de web. Isso pode atrasar todo o projeto de raspagem, especialmente quando lidando com várias páginas. Pode também levar a tempos de raspagem imprevisíveis, extração de dados incompleta ou dados incorretos se certos elementos da página não carregarem corretamente.

Solução

Para resolver esse desafio, é recomendado usar navegadores headless como Selenium ou Puppeteer. Essas ferramentas permitem garantir que uma página esteja totalmente carregada antes da extração de dados, evitando informações incompletas ou incorretas. Configurar timeouts, tentativas de novo ou recarregamentos, e otimizar seu código também podem ajudar a mitigar o impacto do carregamento lento.

Conclusão

Enfrentamos vários desafios ao realizar raspagem de web. Esses desafios incluem bloqueio de IP, verificação de CAPTCHA, limitação de taxa, armadilhas de Honeypot, conteúdo dinâmico e carregamento lento de página. No entanto, podemos superar esses desafios usando proxies, resolvendo CAPTCHAs, controlando a frequência das solicitações, evitando armadilhas, utilizando navegadores headless e otimizando nosso código. Ao abordar esses obstáculos, podemos melhorar nossos esforços de raspagem de web, coletar informações valiosas e garantir conformidade.

Perguntas Frequentes: Perguntas Comuns Sobre Desafios de Raspagem de Web

1. O que é raspagem de web e por que é importante?

A raspagem de web é o processo automatizado de coleta e extração de dados de sites. É amplamente utilizada para pesquisas de mercado, monitoramento de SEO, análise de dados e aprendizado de máquina. Uma raspagem eficiente ajuda as empresas a obter insights e manter uma vantagem competitiva.

2. Por que os sites bloqueiam raspadores de web?

Os sites bloqueiam raspadores para prevenir uso indevido, proteger o desempenho do servidor e garantir dados privados. Métodos comuns anti-bot incluem bloqueio de IP, verificação de CAPTCHA e identificação de JavaScript.

3. Como posso resolver CAPTCHA durante a raspagem de web?

Você pode usar serviços terceirizados de resolução de CAPTCHA como CapSolver. Ele fornece APIs para resolver automaticamente reCAPTCHA, hCaptcha e outros tipos de CAPTCHA, garantindo coleta de dados ininterrupta.

4. Qual é a melhor forma de evitar bloqueio de IP ao raspar sites?

Use proxies rotativos e controle a frequência de suas solicitações. Enviar muitas solicitações em um curto período pode acionar limites de taxa ou banimentos. Proxies residenciais e práticas éticas de raspagem são fortemente recomendados.

5. Como lidar com conteúdo dinâmico ou com muito JavaScript?

Sites modernos frequentemente usam frameworks JavaScript como React ou Vue, que carregam conteúdo dinamicamente. Ferramentas como Puppeteer, Playwright ou Selenium simulam um ambiente de navegador para renderizar e raspar dados de página completa de forma eficaz.

6. Existem preocupações legais ou éticas com a raspagem de web?

Sim. Sempre cumpra os Termos de Serviço (ToS) do site e leis de privacidade de dados (como GDPR ou CCPA). Foque em dados disponíveis publicamente e evite raspar informações sensíveis ou restritas.

7. Como posso acelerar projetos de raspagem de web lentos?

Otimize seus scripts definindo timeouts apropriados, armazenando em cache os resultados e usando solicitações assíncronas. Além disso, resolver CAPTCHAs de forma eficiente com CapSolver e usar proxies rápidos pode reduzir atrasos e melhorar a estabilidade.

Declaração de Conformidade: As informações fornecidas neste blog são apenas para fins informativos. A CapSolver está comprometida em cumprir todas as leis e regulamentos aplicáveis. O uso da rede CapSolver para atividades ilegais, fraudulentas ou abusivas é estritamente proibido e será investigado. Nossas soluções de resolução de captcha melhoram a experiência do usuário enquanto garantem 100% de conformidade ao ajudar a resolver dificuldades de captcha durante a coleta de dados públicos. Incentivamos o uso responsável de nossos serviços. Para mais informações, visite nossos Termos de Serviço e Política de Privacidade.

Mais

Como resolver o reCAPTCHA ao raspar resultados de pesquisa com o Puppeteer

Domine a arte da raspagem de web com o Puppeteer aprendendo a resolver de forma confiável o reCAPTCHA v2 e v3. Descubra as melhores técnicas para solucionar reCAPTCHA com o Puppeteer para coleta de dados em grande escala e automação de SEO.

Adélia Cruz

06-Nov-2025

Como usar IA para scraping na web e resolvendo Captcha

Explore como a IA melhora a eficiência da raspagem de web e automatiza a resolução de CAPTCHA usando a poderosa API baseada em IA do CapSolver.

Adélia Cruz

05-Nov-2025

Como resolver Captchas ao raspar sites de comércio eletrônico

Aprenda como usar a API ImageToText da CapSolver para resolver automaticamente os desafios CAPTCHA em sites de comércio eletrônico. Alcance alta eficiência, estabilidade e extração de dados ininterrupta.

Aloísio Vítor

05-Nov-2025

O que é Coleta de Dados: Últimas Notícias sobre Raspagem da Web em 2024

Aprenda tudo sobre coleta de dados — dos métodos de raspagem da web e aplicações do mundo real até superar barreiras CAPTCHA usando o CapSolver. Descubra como coletar, limpar e analisar dados valiosos de sites, documentos e conjuntos de dados de forma eficiente.

Adélia Cruz

04-Nov-2025

Como resolver CAPTCHA com o Captcha Solver para raspagem de web

Aprenda como usar a API do CapSolver para resolver automaticamente desafios de CAPTCHA complexos, como reCAPTCHA V2 e V3. Obtenha extração de dados eficiente e ininterrupta para seus projetos de raspagem de web.

Adélia Cruz

04-Nov-2025

Melhor Serviço de Resolução de Captcha 2026, Qual Serviço CAPTCHA é o Melhor?

Compare os melhores serviços de resolução de CAPTCHA para 2026. Descubra a vantagem da IA de ponta do CapSolver em velocidade, precisão de 99%+ e compatibilidade com Captcha Challenge

Adélia Cruz

30-Oct-2025